造成能源消耗的主要原因是数据传输。人工智能算法所处理的海量数据更是如此。

因此,省略这一步骤(这也被认为是内存和逻辑进程之间的瓶颈)会产生巨大影响。这正是 2003 年明尼苏达大学提出的一个想法发挥作用的地方。

这促成了从物理学到工程学和计算机科学等众多学科之间的合作。由此产生了许多电路,这些电路如今已被用于智能手表和存储元件中。

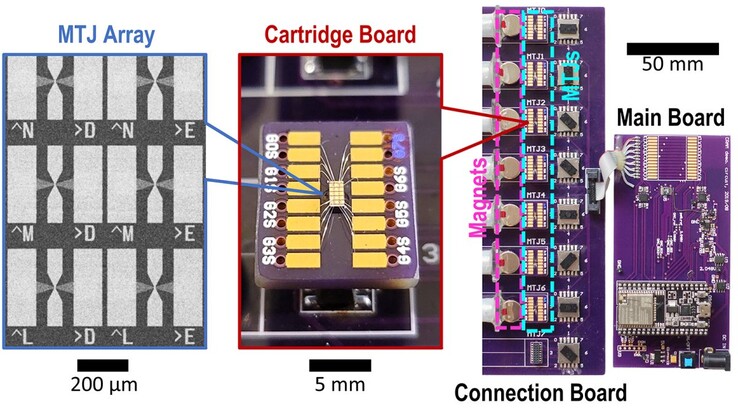

计算随机存取存储器(CRAM)也参与其中。这使得并行进程的实际计算和执行可以直接在主存储器中进行,并在其中的任何位置进行。

不仅仅是新架构

此外,这些并非传统电路,而是磁隧道触点,可以利用电子自旋而非电荷在 0 和 1 之间切换。

在以人工智能为基础的应用中,为了最终实现与传统方法相同的结果,耗电量仅为传统方法的千分之一。从目前和预测的全球神经网络耗电量可以看出,耗电量是多么巨大。根据国际能源机构的数据,2022 年的用电量为 460 太瓦时。最晚到 2026 年,预计将达到 1,000 太瓦时。

在 99.9% 的巨大节约潜力下,将有 999 太瓦时不再需要。这相当于拥有 1.26 亿人口的第四大经济体日本的年耗电量。

论文指出,这还不是最好的结果。进一步的测试可以将能耗降低 1700 或 2500 倍。这种效率的额外提高得益于对 CRAM 进行有针对性的调整,使其适用于各种算法,从而可以更快、更经济地进行计算。

» Notebookcheck多媒体笔记本电脑Top 10排名

» Notebookcheck游戏笔记本电脑Top 10排名

» Notebookcheck低价办公/商务笔记本电脑Top 10排名

» Notebookcheck高端办公/商务笔记本电脑Top 10排名

» Notebookcheck工作站笔记本电脑Top 10排名

» Notebookcheck亚笔记本电脑Top 10排名

» Notebookcheck超级本产品Top 10排名

» Notebookcheck变形本产品Top 10排名

» Notebookcheck平板电脑Top 10排名

» Notebookcheck智能手机Top 10排名

» Notebookcheck评测过最出色的笔记本电脑屏幕

» Notebookcheck售价500欧元以下笔记本电脑Top 10排名

» Notebookcheck售价300欧元以下笔记本电脑Top 10排名