上周,Apple 的研究人员在拥抱脸模型库上推出了一系列"开源 高效 语言 模型"--OpenELM。这四个变体的大小从 2.7 亿个参数到 30 亿个参数不等,最有可能用于Apple 设备上的人工智能。

关于背景,Apple 悄然推出了于 2023 年 12 月悄然推出了名为 MLX 的机器学习框架。接下来是 MLLM 导向图像编辑(MGIE)随后是一系列生成式人工智能工作,包括 Keyframer、Ferret-UI 和 Xcode 中的人工智能代码完成.在大多数情况下,这些项目都是利用Apple 芯片的处理能力,而不是将人工智能功能卸载到云端。

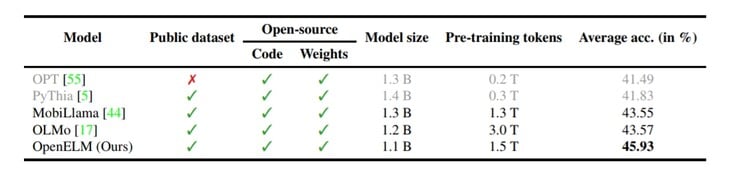

同样,OpenELM 代表了Apple 在设备上实现人工智能的方法。通常情况下,公共 LLM 会利用数千亿(有时是数万亿)个变量来理解用户输入并决定合适的响应。另一方面,小型语言模型(如Microsoft's Phi-3 )仅使用 38 亿个参数,而 Google Gemma 则拥有 20 亿个参数。然而,由于 OpenELM 对转换器模型架构采用了独特的方法,该模型的最低参数仅为 2.7 亿个。

显然,小模型也有一些缺点。首先,OpenELM不是多模式的,参数太少,不可行。此外,正如技术报告 所示,它的事实知识相当少。这个问题困扰着所有类似规模的公共 LLM。不过,由于规模较小,人工智能模型可以托管在本地的手机或笔记本电脑上,而不是云端。

» Notebookcheck多媒体笔记本电脑Top 10排名

» Notebookcheck游戏笔记本电脑Top 10排名

» Notebookcheck低价办公/商务笔记本电脑Top 10排名

» Notebookcheck高端办公/商务笔记本电脑Top 10排名

» Notebookcheck工作站笔记本电脑Top 10排名

» Notebookcheck亚笔记本电脑Top 10排名

» Notebookcheck超级本产品Top 10排名

» Notebookcheck变形本产品Top 10排名

» Notebookcheck平板电脑Top 10排名

» Notebookcheck智能手机Top 10排名

» Notebookcheck评测过最出色的笔记本电脑屏幕

» Notebookcheck售价500欧元以下笔记本电脑Top 10排名

» Notebookcheck售价300欧元以下笔记本电脑Top 10排名

AppleOpenELM 的公开发布有别于公司的一贯做法。从模型的完整框架和评估,到训练日志、预训练配置和 MLX 推理代码,语言模型的方方面面都通过公开发布,供开发人员在不同的用例中调整和重新使用。Hugging Face,供开发人员根据不同的使用情况进行调整和重新利用。从表面上看,如此广泛的发布应该会加强Apple 在人工智能领域的地位,激发研究人员在Apple 设备上玩弄人工智能的可能性。

但这一领域还有其他参与者。微软的 Phi-3 和雷德蒙德的其他开放式 LLM 项目都是非常有实力的竞争对手。谷歌的 2B - 3B Gemma 是另一个对手。虽然上述所有机型的运行速度仍然太慢,但硬件和软件无疑正朝着小语言机型的正确方向发展。

就目前而言,边缘设备,如三星Galaxy S24(亚马逊起价 799 美元),或使用内部的Andes-GPT模型的 OnePlus 12R,都必须依赖云处理。无论Apple 是否将 OpenELM 纳入下一代 iPhone,这家位于库比蒂诺的公司都有可能与谷歌或 Open AI 合作,以实现更重的生成式 AI 功能。