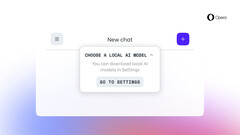

开发者流中的 Opera One 用户将获得重大升级。最新更新允许用户下载并在本地使用 LLM。目前,可供选择的模型来自 50 多个系列,有 150 多种不同的模型可供用户下载并在电脑上运行。

其中一些著名的模型包括来自谷歌的 Gemma,来自 Meta 的 LLaMAMixtral from Mistral AI和LMSYS 的 Vicuna。.这项新功能是人工智能功能下降计划的一部分。也就是说,运行开发者版 Opera One来测试更新。

即便如此,Opera 还是成为第一个允许用户下载和使用本地 LLM 的网络浏览器。对于那些想知道的人来说,在本地运行这些模型通常能提供全面的控制、减少延迟,最重要的是,能更好地保护隐私。但你的电脑确实需要满足一些要求。

例如,该网络浏览器公司表示,本地 LLM 的每个变体都需要超过 2 GB 的存储空间。至于运行模型,Opera 表示它使用的是 Ollama 开源框架。这也意味着浏览器中目前可用的所有模型都是 Ollama 库的子集。好的一面是,Opera 还计划加入其他来源的模型。

资料来源

» Notebookcheck多媒体笔记本电脑Top 10排名

» Notebookcheck游戏笔记本电脑Top 10排名

» Notebookcheck低价办公/商务笔记本电脑Top 10排名

» Notebookcheck高端办公/商务笔记本电脑Top 10排名

» Notebookcheck工作站笔记本电脑Top 10排名

» Notebookcheck亚笔记本电脑Top 10排名

» Notebookcheck超级本产品Top 10排名

» Notebookcheck变形本产品Top 10排名

» Notebookcheck平板电脑Top 10排名

» Notebookcheck智能手机Top 10排名

» Notebookcheck评测过最出色的笔记本电脑屏幕

» Notebookcheck售价500欧元以下笔记本电脑Top 10排名

» Notebookcheck售价300欧元以下笔记本电脑Top 10排名